Что такое дубль? Это не просто повтор на web-сайте. Дубли могут стать причиной целой цепочки проблем, которые не сразу обнаруживаются. В этой статье мы расскажем, в чем опасность дублированного контента, почему нужно проверять сайт на наличие дублей и относиться к ним максимально настороженно? Также вы узнаете, что может произойти, если вообще не контролировать процесс дублирования контента. Читайте нашу статью, чтобы понять, как выявить дубли в ручном и автоматическом порядке. Мы познакомим вас с наиболее эффективными инструментами для решения этой важной задачи.

___________________________________________________________________________________________________________

Что это такое?

Дубли страниц на сайте – это случайно или умышленно дублируемый контент на разных URL. Естественно, мы имеем в виду повторы на одном домене (сайте). Они существенно усложняют продвижение ресурса.

___________________________________________________________________________________________________________

В чем опасность дублей

1. Неправильная идентификация релевантной страницы роботом поисковика

Поясняем на примере: одна и та же страница ресурса может быть доступной по 2 разным URL (ссылкам):

и

Рассказываем, в чем же критичность этой ситуации. У SEO-специалиста имеется конкретный бюджет, который он тратит на продвижение страницы https://site777.ru/catalog/food/. Через определенное количество времени на этот URL начинают ссылаться тематические сайты, ссылка входит в топ-5. Но еще через какой-то промежуток времени робот исключает URL из индекса и взамен ему добавляет https://site777.ru/food/. В конечном итоге страница начинает хуже ранжироваться, привлекает намного меньше трафика. Т. е. бюджет потрачен, а результата особо нет.

2. Увеличение количества времени на переобход вашего сайта роботами поисковых систем

Для сканирования web-сайта роботы поисковиков имеют краулинговый бюджет — максимальное число страниц, которые им надо посетить за конкретный отрезок времени. Если на вашем сайте будет слишком много различных дублей, то робот в итоге может так и не дойти до основного контента на ресурсе. И индексация в итоге будет сильно затянута. Это достаточно серьезная проблема, влияющая на процесс продвижения. Она особенно актуальна для очень больших web-сайтов с огромным числом страниц.

3. Наложение санкций поисковыми системами

Сам по себе дублированный контент не считается поводом для пессимизации сайта и существенного усложнения продвижения. Но это актуально до момента, пока алгоритмы поисковиков не посчитают, что это было сделано намеренно, чтобы попытаться как-то манипулировать выдачей. Если так случится, то ждать санкций долго не придется.

4. Создание неудобств для веб-мастера

Если работу над удалением дублей по каким-то причинам каждый раз откладывать, то в итоге их может образоваться настолько много, что специалист не сможет обработать все отчеты (даже чисто физически), определить и систематизировать причины появления дублей с одинаковым контентом, внести необходимые корректировки. Также такое количество работы в итоге может привести к увеличению риска появления ошибок. Поэтому при появлении первых дубликатов рекомендуем сразу заняться анализом ситуации и их устранением!

Какие дубли встречаются наиболее часто

Неочевидные дубли

Этот вид дублированного контента имеет отличительные черты: он располагается на различных страницах в произвольном порядке. Вместе с этим содержание контента на этих URL будет одинаковым. Теперь предлагаем рассмотреть 3 наиболее частые причины появления дублей на сайтах.

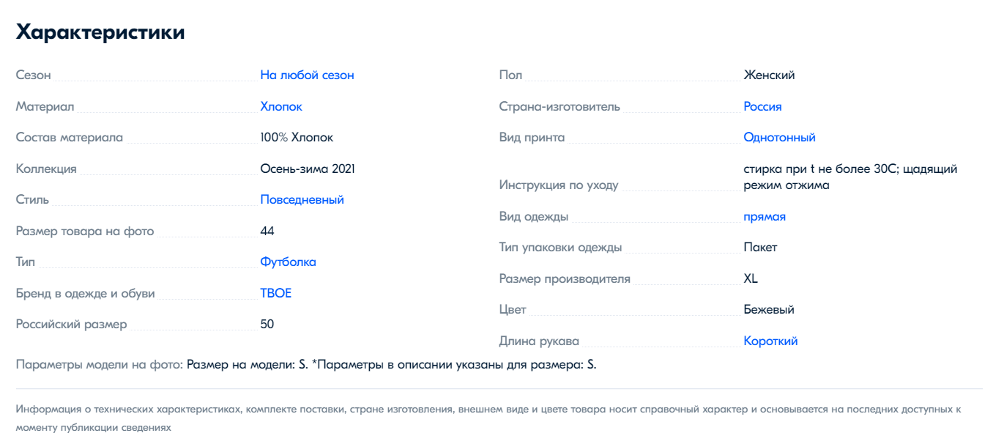

- Товары с близкими по смыслу или незначительно отличающимися характеристиками

Чаще всего у этих товаров описание либо полностью, либо частично дублируется. Так, они могут отличаться, например, небольшим дополнительным предложением или даже словом/цифрой.

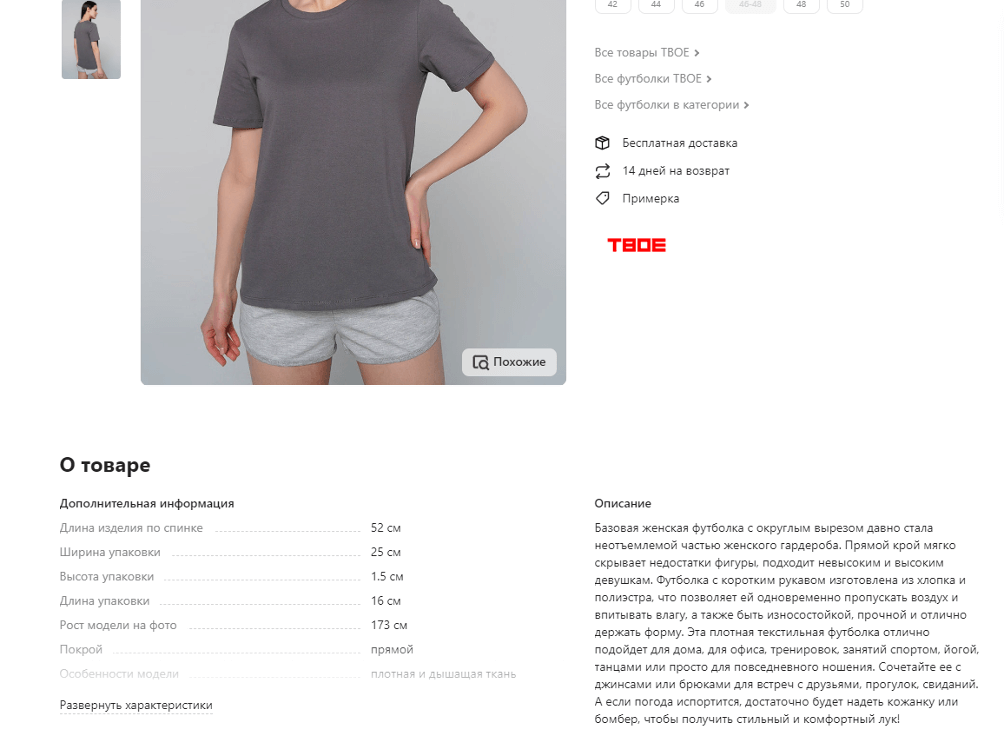

Поясняем на конкретном примере: возьмем сайт магазина, в котором продается одежда. Открываем раздел с футболками и смотрим на карточки одного товара, представленного в различных вариантах: размерах, цветах и пр. Мы видим почти одинаковые или даже полностью схожие описания для разных товаров (минимум одной характеристикой они все же отличаются). И такой контент на карточке не очень хорошо влияет на сайт.

Еще один пример: сайт, на котором продают одежду. Здесь мы видим на карточке один и тот же контент, но для разнообразных цветов/размеров.

С очень высокой долей вероятности краулер (поисковый робот) просто-напросто запутается. Он обойдет первую карточку товара на сайте, а на все схожие с одинаковым контентом, но с одной/двумя разными характеристиками (размерами/материалами/цветами) не обратит внимание.

Как выйти из этой ситуации? Существует 3 варианта. Рассказываем о каждом из них.

1. Надо взять все повторяющиеся блоки текста (на URL со схожим контентом) в следующий тег:

Но у такого решения есть подводные камни, которые надо учитывать: этот тег учитывает только Яндекс, и он не подойдет для отличающихся характеристик товара.

2. Еще один неплохой вариант, который может помочь решить проблему схожего контента на карточках сайта: использовать специальный селектор и выбирать соответствующие характеристики товаров. CSS-селектор будет определять, с каким именно элементом соотносится конкретное CSS-правило. Предварительно необходимо сгруппировать схожие виды товаров в рамках одной карточки (если мы говорим о сайте интернет-магазина).

3. Третий вариант достаточно затратный (не только по времени, но и с финансовой точки зрения). Вам необходимо сделать максимально уникальными (разнообразными) все описания схожих товаров на карточках. Для больших интернет-магазинов создание такого контента слишком затратно и долго, поэтому если выбор все же пал на этот вариант, то рекомендуется начать с тех, что приносят максимум конверсий. Например, уникализировать описания карточек с укороченными юбками, а длинные оставить на потом, если их не так часто покупают. Т. е. надо грамотно расставлять приоритеты.

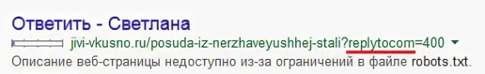

2. Replytocom-комментарии

Replytocom – это дублирующие древовидные комментарии, которые характерны только для сайтов на WordPress. На скрине ниже вы можете увидеть, как это выглядит.

Каждый раз, когда пользователь нажимает на кнопку «Ответить» и отправляет сообщение, WordPress создает новый URL. Это негативно отражается на скорости работы сайта (т. е. он замедляется). А еще такие дубли потом могут оказаться в SERP – на сгенерированной поисковиком странице с результатами поиска.

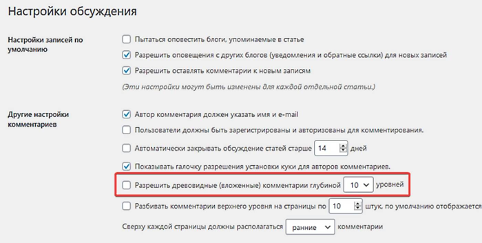

Что же делать в этом случае? Имеется пара рабочих методов:

- установить на сайт модуль комментариев (например Disqus или любой другой). Учтите, что придется отключить стандартные комментарии;

убрать возможность оставления древовидных (вложенных) комментариев. Для этого надо открыть админку WordPress, перейти в глобальные настройки убрать галку в пункте «Обсуждения». Ниже размещен пример:

Кроме вышеописанных способов имеются и более сложные, которые не требуют привлечения сторонних модулей или отключения классических WP-комментариев на своем сайте. Уровень сложности высокий. Придется кодить, а это уже немного другая тема, которую в рамках этой статьи мы не будем затрагивать.

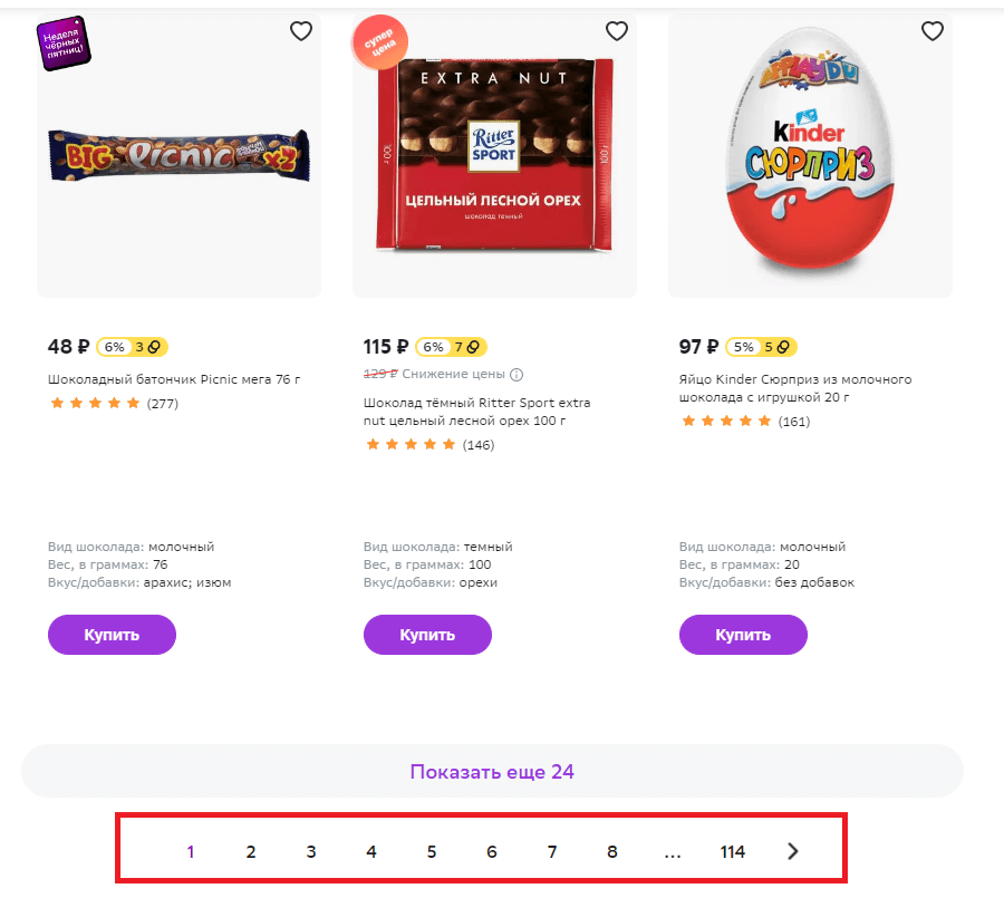

3. Пагинация (пейджинг, pagination, листинг)

В буквальном смысле этот термин означает постраничную навигацию. В процессе нее осуществляется вывод массива данных с разбиением на несколько разных страниц. Пример товаров определенной категории в интернет-магазине. Т. е. пагинация – это порядковая навигация, страницы каталога/книги и пр., по которым мы перемещаемся на сайте.

Индексирование страниц пагинации является одним из наиболее частых вариантов происхождения неявных дублей. Как решить ситуацию? Следует добавить на все страницы следующий код:

<meta name=»robots» content =»noindex, follow» />

Это будет давать сигнал краулерам, чтобы они не обходили их. Важно: добавлять код надо только в секции head-тега!

У Яндекса имеется свое решение: установить rel=»canonical» со всех URL листинга только на главную (обязательно обратите внимание на второй пункт в этой статье). Однако добавление canonical позволяет создать лишь рекомендацию, а не конкретное предписание, поэтому краулеры Яндекса не будут четко ему следовать.

Google не дает таких рекомендаций (использовать rel=»canonical» со всех URL листинга), потому что это может привести к тому, что их краулер при очередном сканировании получит ошибку. Специалисты Google советуют не трогать страницы пагинации, а работать над улучшением пользовательского опыта. Поэтому, если на ваш сайт большая часть трафика идет из поисковой системы Google, устанавливать каноникал не стоит.

Лайфхаки, которые помогут избежать проблем со страницами пагинации

I. Оптимизированные с точки зрения SEO описания категорий товаров (или типов/видов) всегда выводим на главной странице листинга (в общем порядке она идет первой).

II. Добавляем уникальные метатеги, в частности title и description. Заголовки первого уровня аналогично должны быть уникализированы. Решить эту задачу помогут готовые паттерны.

Также при оптимизации важно учитывать следующий момент. На страницы пагинации не рекомендуется добавлять уникальные тексты. Не тратьте бюджет зря: здесь и так разный контент (товары то разные). Т. е. дело тут не в уникальности текстов, а в том, что пользователю бессмысленно попадать из поиска на 5-ю или 7-ю страницу каталога. Он должен попасть на первую страницу с контентом, чтобы начать просмотр с первой страницы и самостоятельно решать, идти ли дальше.

4. Ошибка 404

Некорректно настроенная страница 404 является одной из наиболее частых причин неочевидного дублирования. В этом случае любая страница будет выводить всем один и тот же шаблон, с 200-м кодом ответа сервера. Поэтому очень важно корректно настроить на сайте 404-ю страницу. Чтобы избежать дубли по этой причине, нужно просмотреть все проблемные страницы. Они должны выводить только 404-й код. Еще один способ нивелировать проблему – настроить редирект на страницу с контентом, который искал пользователь.

Итак, мы подробно рассмотрели основные виды неявных дублей страниц на одном и том же сайте. Но в реальности вариантов еще больше. Главное — это понимать процесс формирования таких URL и знать, как выявить и удалить.

Явные (очевидные) дубли

Это страницы с идентичным содержимым, когда повторяется и сам контент, и порядок его расположения на странице сайта. К возникновению очевидных дублей может привести ряд стандартных ошибок, рассмотрим их подробнее.

Ошибка № 1: страница для печати

Даем пример для наглядности:

https://sape.ru/blog/new-article.html

https://sape.ru/blog/new-article.html/?print=1

Как мы можем видеть, дубли появляются при генерации печатной версии страницы с помощью функции ?print. И это всегда дубль, потому что содержимое страницы полностью повторяет оригинальный URL.

Решить эту проблему возможно с помощью хорошо знакомых директив Disallow и Clean-param. Последнюю «понимает» только Яндекс. А Disallow создана специально для краулеров Google. Соответствующие директивы нужно прописать в файле robots.txt. Приводим пример, как мы это сделаем для всех краулеров:

User-agent:*

Disallow: /*print.php

Такое правило актуально абсолютно для всех поисковиков. Если вам требуется ограничение индексирования print-страниц только для краулера Яндекса, можете смело использовать Clean-param, если только для Google – берите директиву Disallow.

Ошибка № 2: слеш (/) после URL

Не все обращают внимание на такой нюанс, как использование двух форматов адресов: со слешем (косой чертой в конце URL) и без него. Показываем вам, как это выглядит:

https://sape.ru/blog/

https://sape.ru/blog

Слеш в конце URL становится одной из очень частых причин появления явных дублей на одном сайте. Но и эту проблему можно достаточно легко и быстро решить: надо просто сделать редирект с HTTP-кодом 301.

Если говорить о выборе предпочтительного варианта (URL со слешем в конце либо без него), то надо понять, каких ссылок на вашем сайте изначально больше. Если с косой чертой, то значит можно оставить URL с / в конце, если наоборот, то оставляем адреса без /.

У Яндекса индексация ссылок со слешем в конце и без него происходит одинаково. При выборе адреса, который останется в поиске, важно учитывать адрес, по которому сейчас происходит индексация страниц (если редирект пока не установлен). Например, если в поиске уже есть страницы без /, то стоит сделать перенаправление с URL со слешем на ссылки без него. Это может помочь избежать доп. смены адресов в поиске.

Ошибка № 3: один и тот же товар размещен на разных URL (актуально для интернет-магазинов)

Рассмотрим эту ошибку, приводящую к появлению дублей, на конкретном примере. У вас интернет-магазин Megamag, в котором продается техника бренда Apple. И одна и та же модель iPhone размещена на двух страницах с разными URL. В этом случае адреса будут выглядеть следующим образом:

https://megamag.ru/apple/iphone-14

и

https://megamag.ru/iphone-14

Один из вариантов решения проблемы – настройка каноникала на главную сайта. Здесь есть 2 варианта: при помощи специального тега линк или плагинов. Рассказываем о каждом из них.

Плагины. Легче всего управлять каноническими страницами с помощью плагинов для CMS. Так, для сайта на WordPress для назначения каноникал подойдет плагин Yoast SEO. С помощью него очень просто выполнить настройку, буквально в пару кликов.

Тег <link>. Еще один актуальный вариант для настройки каноникал. Например, вам надо указать краулеру, что URL https://megamag.ru/apple/iphone-14 является самым главным. для этого нужно добавить в раздел всех дублей такую запись:

<link rel=»canonical» href=https://megamag.ru/apple/iphone-14″/>

И все готово.

Ошибка № 4: «www» в начале ссылок

URL также могут отличаться и по наличию/отсутствию «www» в начале адреса. Приведем пример, как выглядят такие ссылки:

https://www.sape.ru/blog/

https://sape.ru/blog

Избавиться от таких дублей можно по-разному. Вначале нужно определиться и указать главное зеркало. Рассказываем, как это сделать.

Как склеить зеркала в Яндексе

1. Открыть Яндекс.Вебмастер и удостовериться, что в разделе «Сайты» есть оба варианта ресурса: с «www» и без. Также на этом этапе надо решить, какая версия домена будет считаться главным зеркалом.

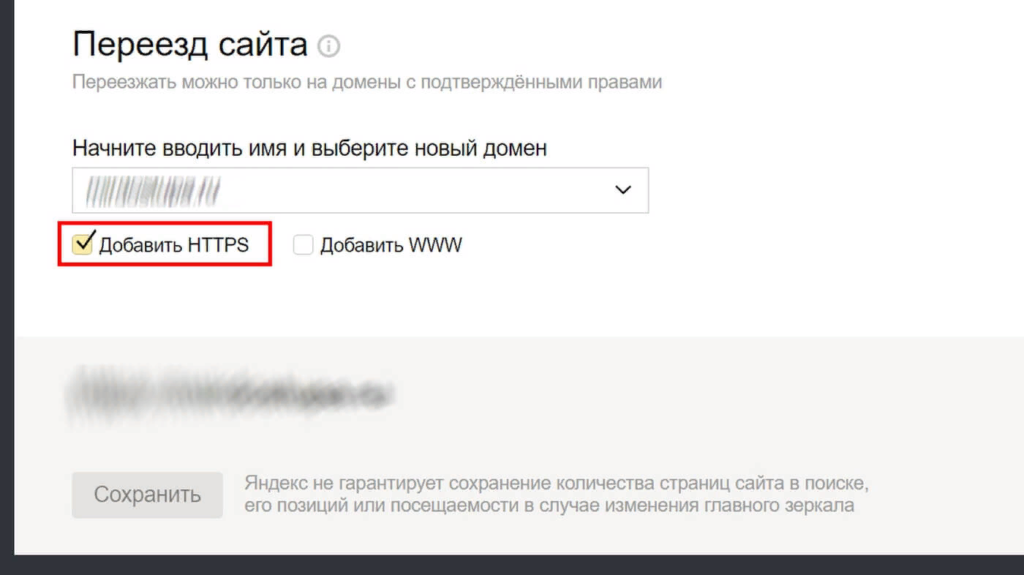

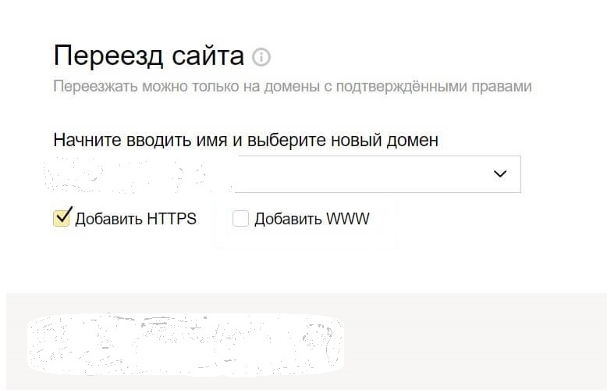

2. Выбрать URL, с которого будет идти переадресация. Для этого надо выбрать его в верхней части Вебмастера, в разделе «Индексирование» – «Переезд сайта».

3. Убрать выделение с чекбокса «Добавить HTTPS».

Примерно за 2 недели Яндекс произведет склейку зеркал и переиндексирует страницы. После этого в поиске появятся URL без www.

Важный момент! Раньше для указания на главное зеркало требовалось прописывать директиву Host в файле robots.txt. Сейчас она не поддерживается. Часть веб-мастеров до сих пор указывают ее (для подстраховки). Но это не обязательно делать, достаточно провести склейку в Яндекс.Вебмастере.

Как склеить зеркальные домены в Google

До 2020 года можно было подтвердить права на обе версии ресурса (с www и без) в Google Search Console и указать предпочтительный адрес в «Настройках сайта». Теперь указать поисковику на главное зеркало возможно 3 следующими способами:

- настроить 301-й редирект на основное зеркало;

- по рекомендациям Гугла настроить канонические страницы за счет добавления в код тега <link> с атрибутом rel=»canonical»;

- прибавить каноникал-заголовок в ответ web-страницы (ограничений по количеству страниц нет + их размер остается изначальным).

Ошибка № 5: CGI-параметры в URL

Еще одна популярная причина появления массовых дублей на сайте. В этом случае имеются в виду динамические параметры, изменяющие содержимое страницы. GET-параметры очень легко идентифицируются. Для этого нужно найти во второй части URL знак «?».

Убрать дубли, которые возникают из-за GET-параметров, можно, задав правило в robots. Можно включить любые виды параметров, например разметку Google Рекламы или UTM.

User-agent: *

Disallow: /*?utm_source=

Disallow: /*?utm_medium=

Disallow: /*?utm_campaign

Disallow: /*?sid=

Disallow: /*?gclid=

Еще один рабочий способ – использовать директиву. Но ее поддерживает только Яндекс, поэтому мы не станем рассматривать ее подробнее. Но вы также можете использовать обе директивы (Clean-param и Disallow) в одном файле robots.

Ошибка № 6: тип протокола передачи гипертекста в URL (HTTPS-url и HTTP-url)

Если вы уже приобрели SSL-сертификат и сайт переехал на HTTPS, то у вас наверняка образовалась масса дублированного контента, потому что краулеры идентифицируют домены вида https://site.ru и http://site.ru как неодинаковые. Для решения проблемы дубликатов страниц после переезда на HTTPS-протокол нужно:

- зайти в Яндекс.Вебмастер и выбрать главное зеркало;

- в разделе «Индексирование» – «Переезд сайта» убрать галку напротив чекбокса «Добавить HTTPS».

Важно! Не забудьте точно убедиться в том, что все перенаправления работают корректно. Уделите особое внимание проверке самих команд редиректов. Очень часто ошибки возникают именно из-за них.

Находите свой вариант работы с дубликатами страниц

Одни и те же дубли URL могут закрываться от индексации самыми разными способами. Работают и редиректы, и канонизация страниц, и метатег robots, и директивы robots.txt. Но важно учитывать отдельные рекомендации разных поисковиков.

Так, Google не рекомендует закрывать доступ к дублям при помощи файла robots.txt либо метатега robots со значениями noindex и nofollow. Поисковик советует использовать 301-й редирект и rel=»canonical». А Яндекс выступает за robots.txt, имеется даже собственная директива Clean-param.

Вам необходимо проанализировать ситуацию и выбрать оптимальные в вашем случае способы удаления дублей. Пример: если вы ориентируетесь на аудиторию Казахстана и некоторых стран Запада, то лучше всего взять за основу рекомендации Google. Ваша ЦА – Россия? Тогда смело берите рекомендации Яндекса.

Не стоит пытаться закрыть дубли сразу всем арсеналом инструментов. Это бессмысленная работа, которая, кроме всего прочего, будет лишь путать. Также не надо излишне перегружать сервер 301 редиректами, потому что это может значительно увеличить нагрузку на него.

Как выявить дубли страниц

Все способы достаточно простые. Они помогут успешно найти дубли, благодаря чему можно будет составить план их устранения и дальнейшего продвижения. Какой способ выбрать, решать только вам.

Первый способ. Ручной.

Дубли легко ищутся в поисковиках. Надо лишь знать особенности своей CMS. Чтобы найти дубли, вбейте в поисковую строку следующий запрос:

site:{ваш домен} inurl:{фрагмент URL}

Например, мы знаем, что на сайте адреса страниц пагинации формируются при помощи GET-запроса ?page=. Нам надо ввести в Google запрос и посмотреть, есть ли дубли. Поисковик может выдать дублирующиеся страницы с запросами: ?start=, ?limit=, ?category_id=. По ним надо будет проверить ресурс на наличие дублей. Аналогичную операцию повторяем и в Яндексе.

Ручной способ нахождения дубликатов страниц прекрасно подходит для быстрого анализа сайта. Для системной работы с ресурсом лучше всего использовать другие способы.

Второй способ. Используем Яндекс.Вебмастер

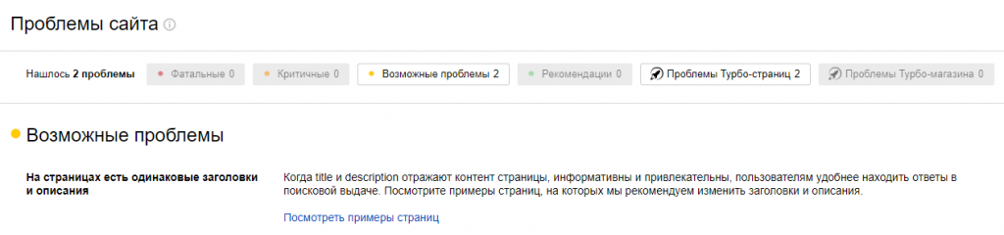

Информацию о наличии дублей страниц, обнаруженных на сайте роботом Яндекса, можно увидеть в разделе «Диагностика». Уведомление о страницах с одинаковыми метатегами title и description выглядят так:

Также Яндекс информирует о наличии страниц с незначащими GET-параметрами.

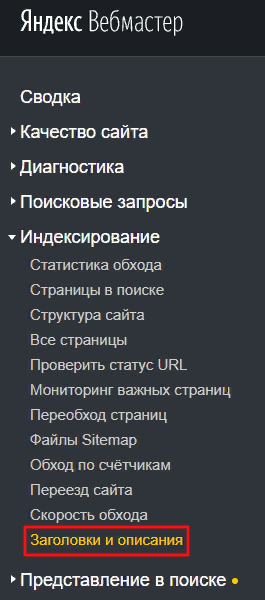

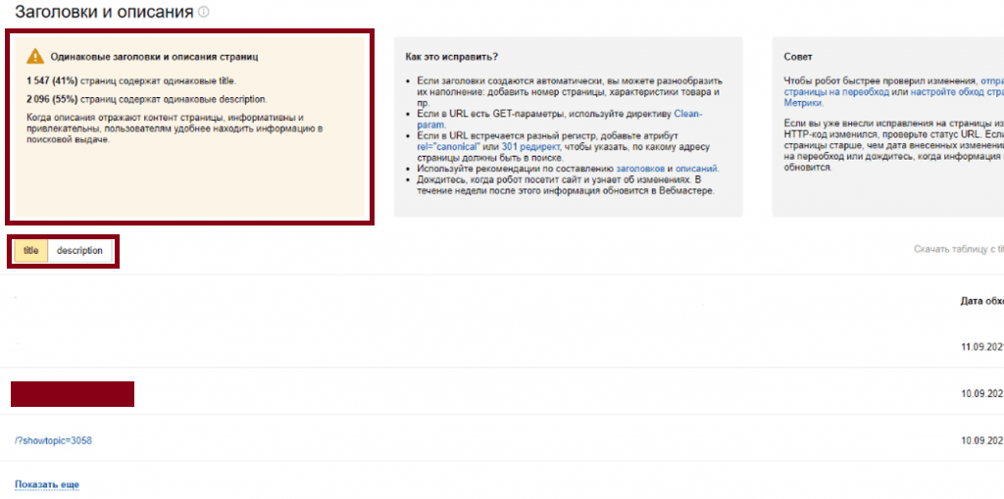

Примеры URL с одинаковыми метатегами description и title находятся в разделе «Индексирование» и подразделе «Заголовки и описания». Пример:

Если система обнаружит дубли метатегов, то здесь будет размещаться вся информация о числе затронутых страниц (аналогичное уведомление можно найти в «Сводке»), а также примеры, советы и рекомендации. Таблица с URL выгружается в двух форматах на выбор: CSV и XLS.

Лучше всего не дожидаться уведомлений и самостоятельно искать дубли страниц при помощи Яндекс.Вебмастер. Алгоритм довольно простой.

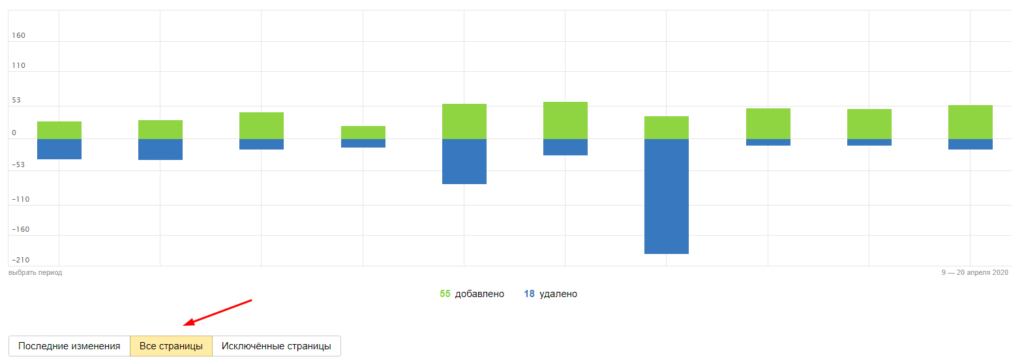

- Зайдите в «Страницы в поиске» (раздел «Индексирование»).

- Найдите и активируйте вкладку «Все страницы». Далее выгрузите отчет в удобном формате.

3. Проанализируйте информацию и найдите подозрительные ссылки, похожие на дубли. Для удобства можно использовать фильтры по частям URL, которые указывают на дублирование.

Третий способ. С помощью парсера проиндексированных страниц.

В процессе отслеживания индексации в Яндекс достаточно проблематично сопоставлять данные с Google. Поэтому специалистам приходится использовать ручной способ и перепроверять, был ли проиндексирован дубль. Эту проблему может помочь избежать парсер проиндексированных страниц.

Четвертый способ. Обратиться к экспертам.

Если у вас нет времени или желания на поиск и устранение дублей, вы можете заказать аудит сайта. Это доступный по цене продукт, который также даст массу полезной информации о вашем ресурсе: о наличии ошибок в HTML-коде, метатегах, заголовках, структуре, перелинковке, внутреннем юзабилити, оптимизации контента и многом другом. Эксперты дадут полезные и четкие рекомендации, которые помогут сделать сайт более привлекательным для поисковых систем и пользователей.

Это особенно важно, если вы только планируете разработку. Доверьте работу экспертам на самом первом этапе. Это поможет предотвратить и оперативно решить многие проблемы, сэкономить ваши силы и деньги.

Advisor.Sape — сервис аудитов от компании Sape. Он был разработан на основе многолетнего опыта поискового продвижения и при участии экспертов с огромным опытом и исключительными компетенциями.

Вы можете освободить себя от рутины и риска ошибок, заказав нужный аудит:

- технический и поисковый,

- архитектуры сайта и его текстовой оптимизации,

- коммерческих факторов,

- ссылочной оптимизации,

- юзабилити-аудит.

С Advisor.Sape вы сможете максимально быстро найти и удалить дубли, исправить все скрытые ошибки и недочеты сайта, которые мешают ему успешно продвигаться. Использованием Advisor.Sape вместе с Wizard.Sape вы сможете еще и сэкономить деньги на продвижение.

Выводы

Дубликаты — это страницы с одинаковым или очень схожим содержимым, размещенные на одном ресурсе. Чаще всего они возникают из-за особенностей функционирования CMS, ошибок в настройке 301-х редиректов или директивах robots.txt. Неявные и явные дубли страниц могут затруднять индексацию, мешать качественному SEO и усложнить работу веб-мастеру.

Появление дублей можно предотвратить на самом первом этапе технической оптимизации ресурса, до того как начнется индексация страниц. Теперь вы знаете, что для каждого дубликата есть свои варианты профилактики и устранения ошибок. Если произошло так, что большее число дублей с вашего сайта уже попало в индекс, классифицируйте их и затем устраните оптимальным способом. После этого поисковики со временем удалят их из выдачи, и вы сможете спокойно заниматься дальнейшим продвижением сайта, развитием группы в соцсети и пр.